ИИ теперь используется для создания детской порнографии и шантажа подростков: Эксперт по цифровой безопасности

Преступники предоставляют пошаговые руководства по созданию глубоких подделок детей в темной паутине

Эксперт по цифровой безопасности предупреждает о том, что преступники используют искусственный интеллект для создания детской порнографии

CMO компании Canopy Ярон Литвин рассказывает о том, как преступники используют технологию deepfake для шантажа подростков и создания детской порнографии.

Стремительное развитие программ искусственного интеллекта (ИИ), способных генерировать реалистичные изображения, привело к взрыву детской порнографии и попыткам шантажа со стороны преступников, решивших использовать детей и подростков в своих целях.

Ярон Литвин (Yaron Litwin), CMO и эксперт по цифровой безопасности компании Canopy, ведущего ИИ-решения для борьбы с вредным цифровым контентом, рассказал Fox News Digital, что педофилы используют развивающиеся инструменты различными способами, часто с целью создания и распространения в Интернете изображений сексуальной эксплуатации детей.

Один из таких способов включает в себя редактирование подлинной фотографии полностью одетого подростка и превращение ее в изображение обнаженной натуры. В одном из реальных примеров, приведенных Литвином, 15-летний подросток, интересующийся фитнесом, присоединился к онлайновой сети любителей тренажерных залов. Однажды он поделился с группой фотографией своей обнаженной груди после тренировки. Это изображение было взято, отредактировано и использовано для шантажа подростка, который изначально думал, что его фото безобидно и находится в безопасности в руках товарищей по спортзалу.

В 2022 году крупнейшие социальные сети сообщили о 9%-ном увеличении количества материалов, подозреваемых в сексуальном насилии над детьми, размещенных на их платформах. Из этих сообщений 85% поступило с цифровых платформ Meta, таких как Facebook, Instagram и WhatsApp.

Руководитель отдела безопасности Meta Антигона Дэвис ранее заявляла, что 98% опасного контента удаляется до того, как кто-то сообщит о нем ее команде, и компания сообщает о большем количестве материалов о сексуальном насилии над детьми (CSAM), чем любой другой сервис.

По словам Литвина, процесс редактирования существующих изображений с помощью искусственного интеллекта стал невероятно простым и быстрым, что часто приводит к ужасным последствиям для семей. Эта простота использования также переносится на создание полностью сфабрикованных изображений детской сексуальной эксплуатации, которые не опираются на подлинные фотографии.

"Это не настоящие дети", - сказал Литвин. "Это дети, которые создаются с помощью ИИ, и по мере того, как этот ИИ, по мере того, как алгоритм получает все больше таких изображений, он может, по сути, улучшить себя, причем в негативном смысле"

Согласно недавнему анализу, созданные ИИ изображения детей, вовлеченных в половые акты, могут потенциально нарушить работу центральной системы отслеживания, которая блокирует CSAM в сети. В своем нынешнем виде эта система предназначена только для обнаружения известных изображений насилия, а не сгенерированных. Эта новая переменная может заставить правоохранительные органы тратить больше времени на определение того, является ли изображение реальным или сгенерированным ИИ.

По словам Литвина, эти изображения также ставят уникальные вопросы о том, что нарушает государственные и федеральные законы о защите детей и порнографии. Хотя сотрудники правоохранительных органов и представители Министерства юстиции утверждают, что такие материалы незаконны, даже если ребенок, о котором идет речь, сгенерирован искусственным интеллектом, ни одно подобное дело не рассматривалось в суде.

Более того, прошлые юридические споры указывают на то, что такой контент может быть серой зоной в американском законодательстве. Например, в 2002 году Верховный суд отклонил несколько положений, запрещающих виртуальную детскую порнографию, заявив, что это постановление слишком широкое и может даже охватить и криминализировать изображения подростковой сексуальности в популярной литературе.

В то время главный судья Уильям Х. выступил со зловещим несогласием, в котором предсказал многие этические проблемы новой революции ИИ.

"Конгресс крайне заинтересован в том, чтобы обеспечить возможность соблюдения запретов на реальную детскую порнографию, и мы должны согласиться с его выводами о том, что быстро развивающиеся технологии вскоре сделают это практически невозможным", - сказал он.

Ряд других факторов обострил проблему сексуальной эксплуатации детей в Интернете. В то время как инструменты генеративного ИИ принесли огромную пользу в создании новых фотографий, произведений искусства и иллюстрированных романов, педофилы теперь используют специальные браузеры для общения на форумах и обмена пошаговыми руководствами о том, как легко создавать новые запрещенные материалы. Затем эти изображения распространяются или используются для создания фальшивой онлайн-персоны, чтобы общаться с детьми и завоевывать их доверие.

Хотя большинство программ искусственного интеллекта, таких как Stable Diffusion, Midjourney и DALL-E, имеют ограничения на то, на какие подсказки будет реагировать система, Литвин говорит, что преступники начинают использовать алгоритмы с открытым исходным кодом, доступные в темной паутине. В некоторых случаях легкодоступные программы искусственного интеллекта также можно обмануть, используя специфические формулировки и ассоциации, чтобы обойти установленные защитные барьеры и ответить на потенциально опасные запросы.

По словам Литвина, из-за большого количества сгенерированных откровенных материалов эти изображения сложно блокировать и фильтровать, что облегчает заманивание детей и их ознакомление с вредным контентом.

"Если бы я не работал в этой отрасли, то не знаю, как родитель, был бы я полностью осведомлен о том, к чему это может привести и что можно сделать", - добавил Литвин.

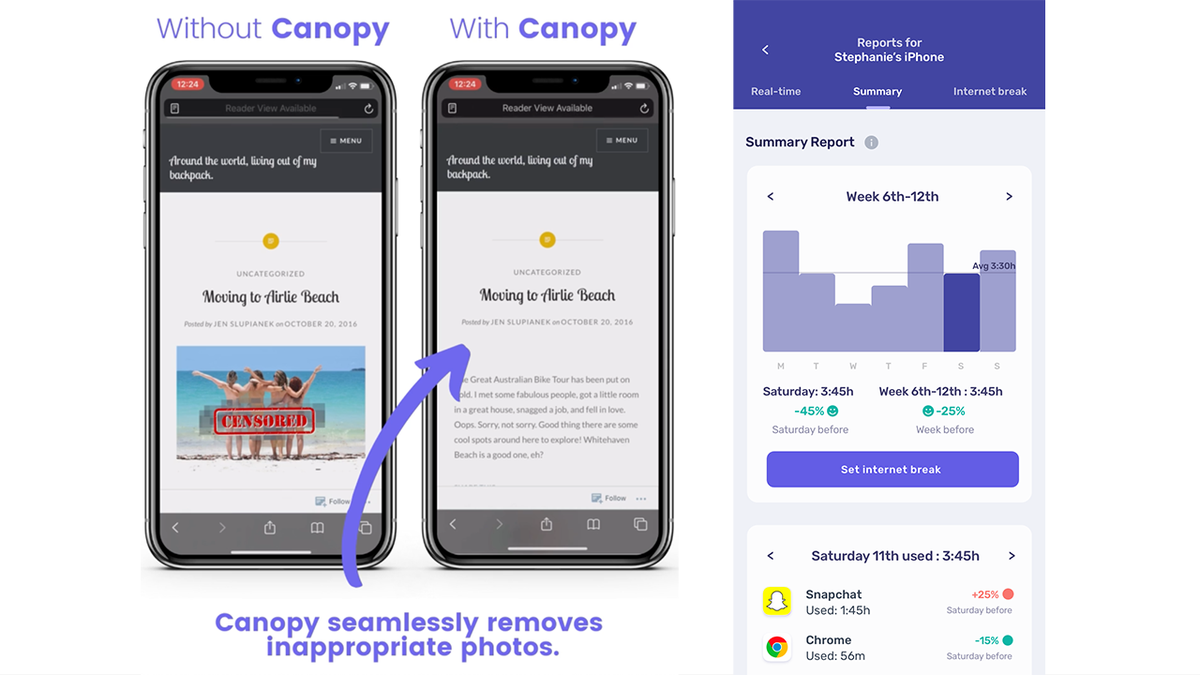

Однако он отметил, что хотя ИИ потенциально может навредить детям, приложение Canopy было разработано в результате 14-летнего обучения алгоритмов ИИ, чтобы стать примером "ИИ во благо"

Canopy - это цифровое приложение для родителей, которое обнаруживает и блокирует неподобающий контент за миллисекунды до того, как он попадет на экран детского компьютера или телефона.

"Когда Вы просматриваете Интернет, когда Вы заходите в социальные сети, если появляется изображение, оно отфильтровывается. Большинство продуктов просто блокируют весь сайт. Как только он определит потенциальное изображение. Мы можем просто отфильтровать все, чтобы Вы могли просматривать сайт", - говорит Литвин.

Решение использует передовые вычислительные технологии, включая искусственный интеллект и машинное обучение, для распознавания и фильтрации неприемлемого контента в Интернете и популярных приложениях социальных сетей.

В дополнение к интеллектуальному фильтру, который обнаруживает и блокирует неприемлемые изображения и видео, Canopy предлагает оповещения о секстинге, которые помогут обнаружить и предотвратить распространение неприемлемых фотографий.

"[Ребенок] может думать, что на другом конце находится ребенок его возраста, а на самом деле это не так. Таким образом, мы можем поставить барьер между, возможно, плохим решением и позволить родителям решить, хотят ли они разрешить это или нет", - сказал Литвин.

Решение также включает в себя функцию предотвращения удаления, которая гарантирует, что Canopy нельзя будет удалить или отключить без разрешения родителей или опекунов.

Николас Ланум - видеоредактор Fox News Digital.